- 大模型帶來了哪些算力新需求?

- 2023年11月27日來源:中國IDC圈

提要:隨著人工智能技術的快速發展,AI大模型已成為當今世界計算力需求增長的主要驅動力。這些模型不僅在理論研究上取得突破,也在實際應用中發揮著越來越重要的作用。日漸普及的AI大模型正推動著全球及中國的算力基礎設施變革。

11月24日,投資60個億的中國聯通長三角(蕪湖)智算中心項目開工;

11月22日,面向汽車研發的阿爾特(無錫)智算中心正式啟用;

11月21日,首期規劃1000PFLOPS智算能力的中國移動智算中心(武漢)落地;

11月20日,首個國產化智算中心項目在貴安正式簽約;

此外,如鄂爾多斯、南昌等地,均有智算相關的土地規劃出爐……在過去一周中,幾乎每一天都有智算相關項目消息傳出。而這,幾乎是最近一年來的常態,智算中心建設已經進入了爆發期。

智算的火爆,背后是AI大模型興起,以及其對算力帶來的全新需求。

大模型算力消耗有多恐怖?

隨著人工智能技術的快速發展,AI大模型已成為當今世界計算力需求增長的主要驅動力。這些模型不僅在理論研究上取得突破,也在實際應用中發揮著越來越重要的作用。日漸普及的AI大模型正推動著全球及中國的算力基礎設施變革。

AI大模型需要多少算力,我們可以從ChatGPT的訓練算力消耗中窺得一斑。OpenAI的報告顯示,訓練一次1746億參數的GPT-3模型需要的算力約為3640PFlops-day。雖然ChatGPT 4的細節沒有公布,但據ARK Invest估算,GPT-4參數量最高達15000億個,算力需求最高可達31271 PFlops-day。

這僅僅是ChatGPT的訓練需求——在ChatGPT引發了廣泛關注后,世界各國都在殺入大模型領域,各類大模型產品層出不窮。在不到一年的時間里,僅我國國內,就發布了不下200個大模型產品。

可想而知,這些大模型需要的算力將有多么恐怖。

算力基礎設施面臨的挑戰

算力需求的暴增,對算力基礎設施帶來了兩個方向的挑戰。

一方面是計算力生產的挑戰。隨著摩爾定律在物理法則層面的極限到來,依賴單芯片的算力已經無法滿足超大規模算力的需求,因此需要更多的芯片聯合工作,就此數據中心的規模越來越大,以集群式的算力中心建設已經成為常態。

一方面是生產算力所需環境的挑戰。在算力中心超大規模化發展的情況下,算力中心能源供給的充足和穩定,以及龐大能源消耗帶來的熱量如何有效的散發,也成為了一個需要面對的現實話題。

而這些也僅僅是AI大模型訓練中需要的算力,隨著大模型產品的落地和普及,推理型的算力需求將進入增長期,其增量將超過訓練需求,長遠看其算力需求總量或將與訓練需求平齊甚至超越。

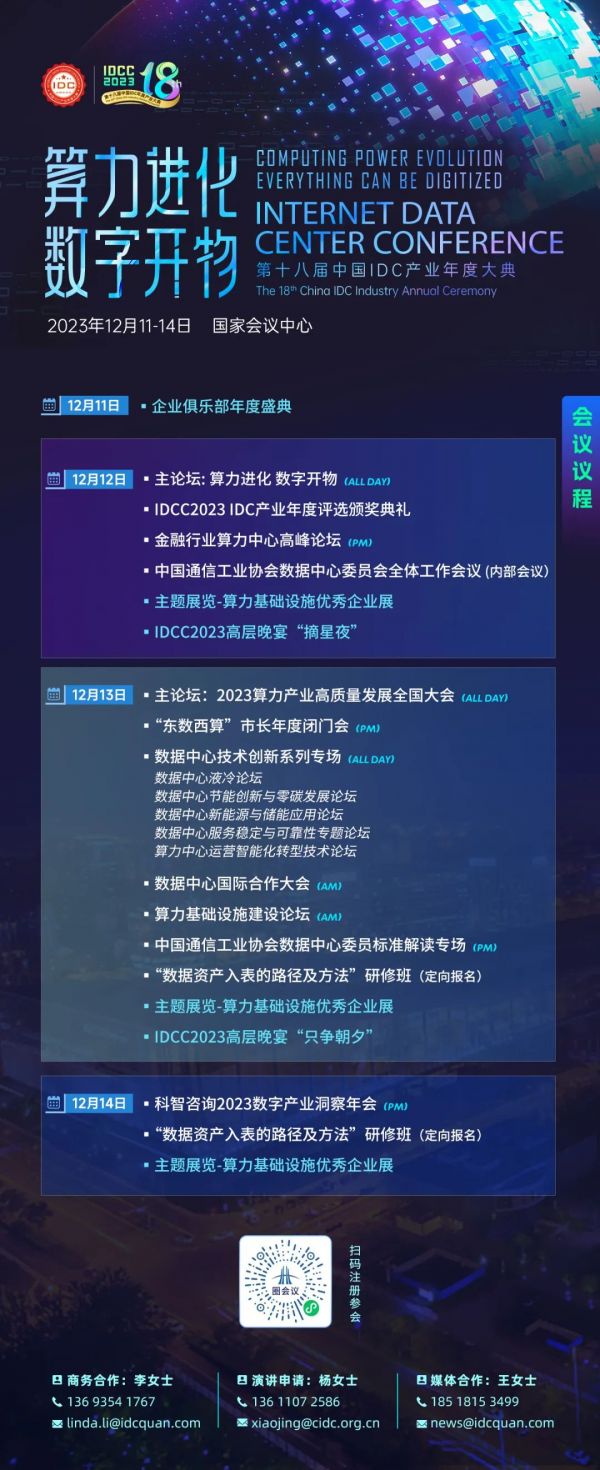

因此,AI大模型帶來的算力新需求不僅是技術挑戰,也是基礎設施發展的重要機遇。特別是在中國市場,數據中心行業的迅猛增長預示著巨大的潛力和機遇。在12月12日-14日舉辦的第十八屆中國IDC產業年度大典上,將設置多個會場和議題,邀請來自快手、世紀互聯、超聚變、科大訊飛、智譜AI、比亞迪等智算產業上下游專家、企業,共同探討如何面對算力挑戰。

第十八屆中國IDC產業年度盛典(IDCC2023)將于2023年12月12-14日在北京國家會議中心隆重舉行,大會主題為“算力進化 數字開物”,聚焦算力產業熱點話題,匯聚業內精英人士,共同探討數字經濟的發展方向和未來趨勢。歡迎報名,現場參與!